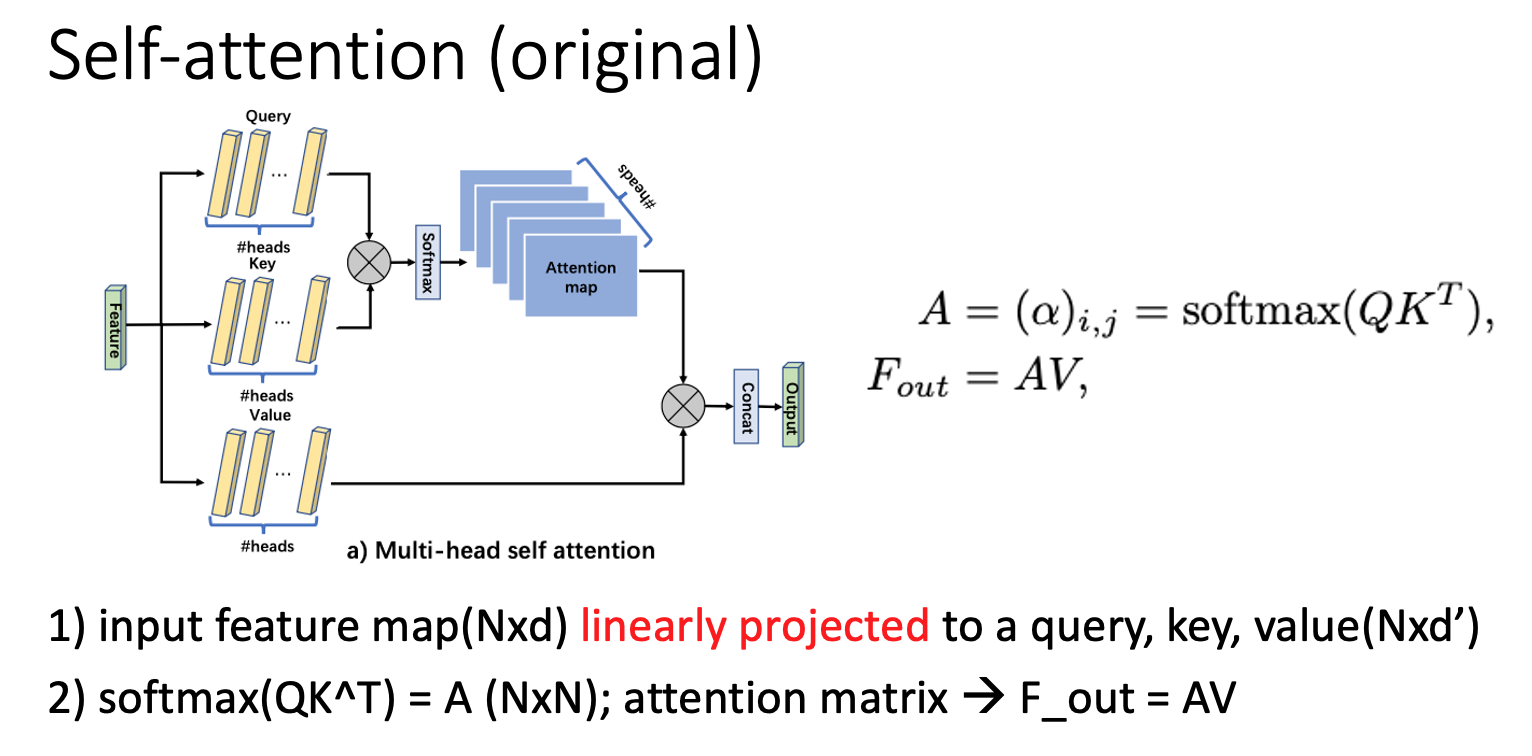

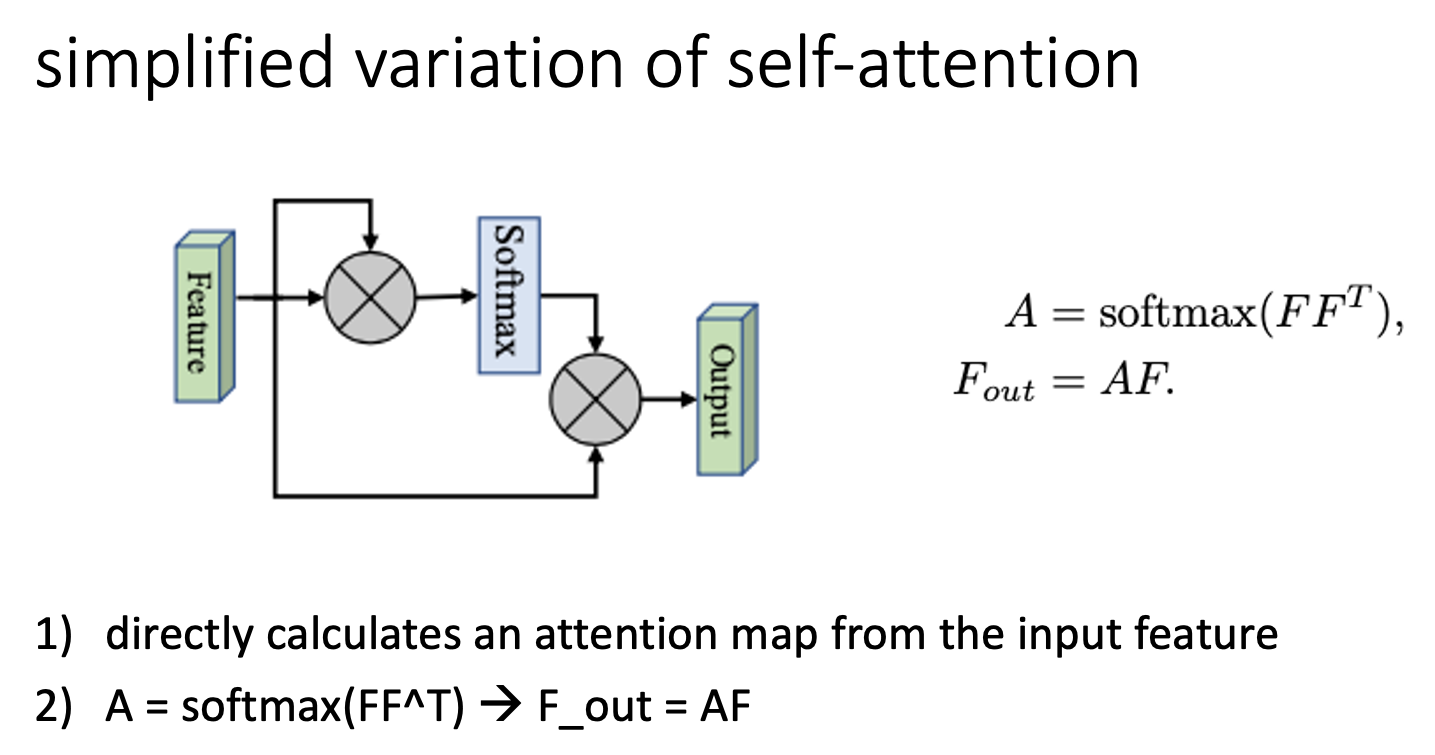

self-attention은 하나의 샘플의 각각의 다른 위치로부터 features를 합하여 각 position을 강조하는 방법이다. 하지만 location의 개수에 따라 제곱으로 computational complexity가 증가한다. 그리고 다른 샘플을 고려하지 않는다는 단점이 있다.

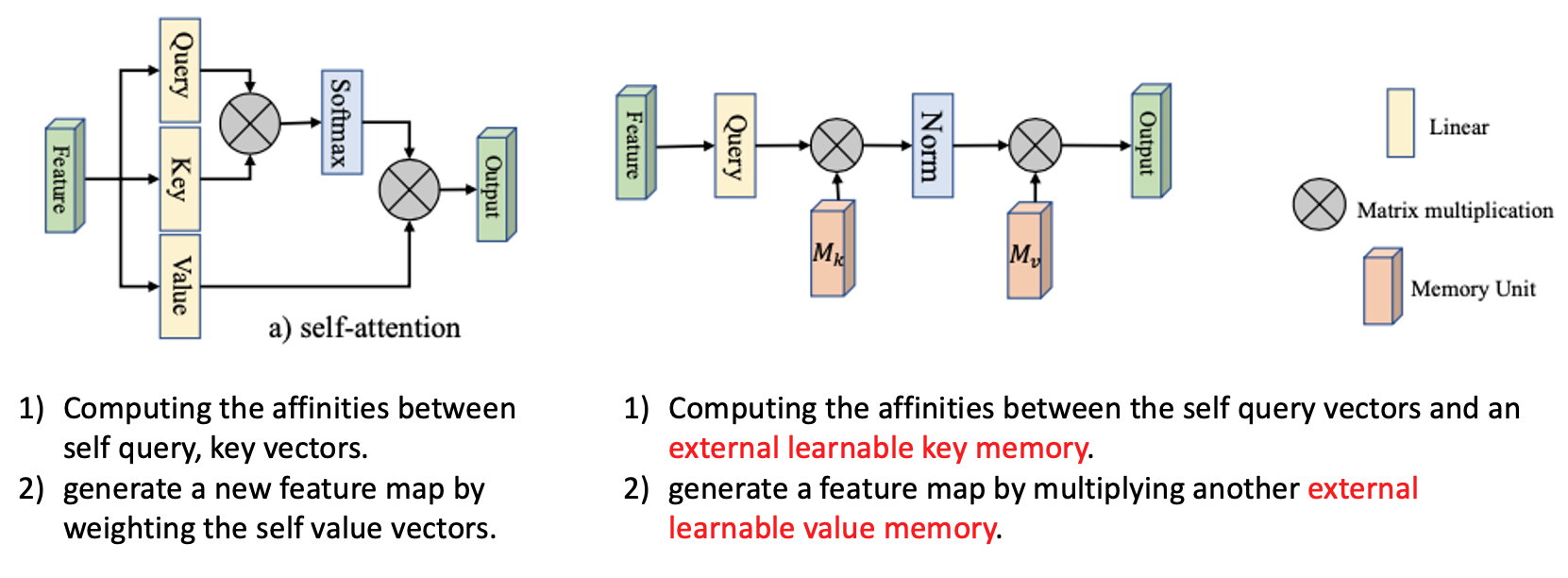

왼쪽은 기존의 self-attention diagram이고 우측은 저자가 제시하는 방법이다.

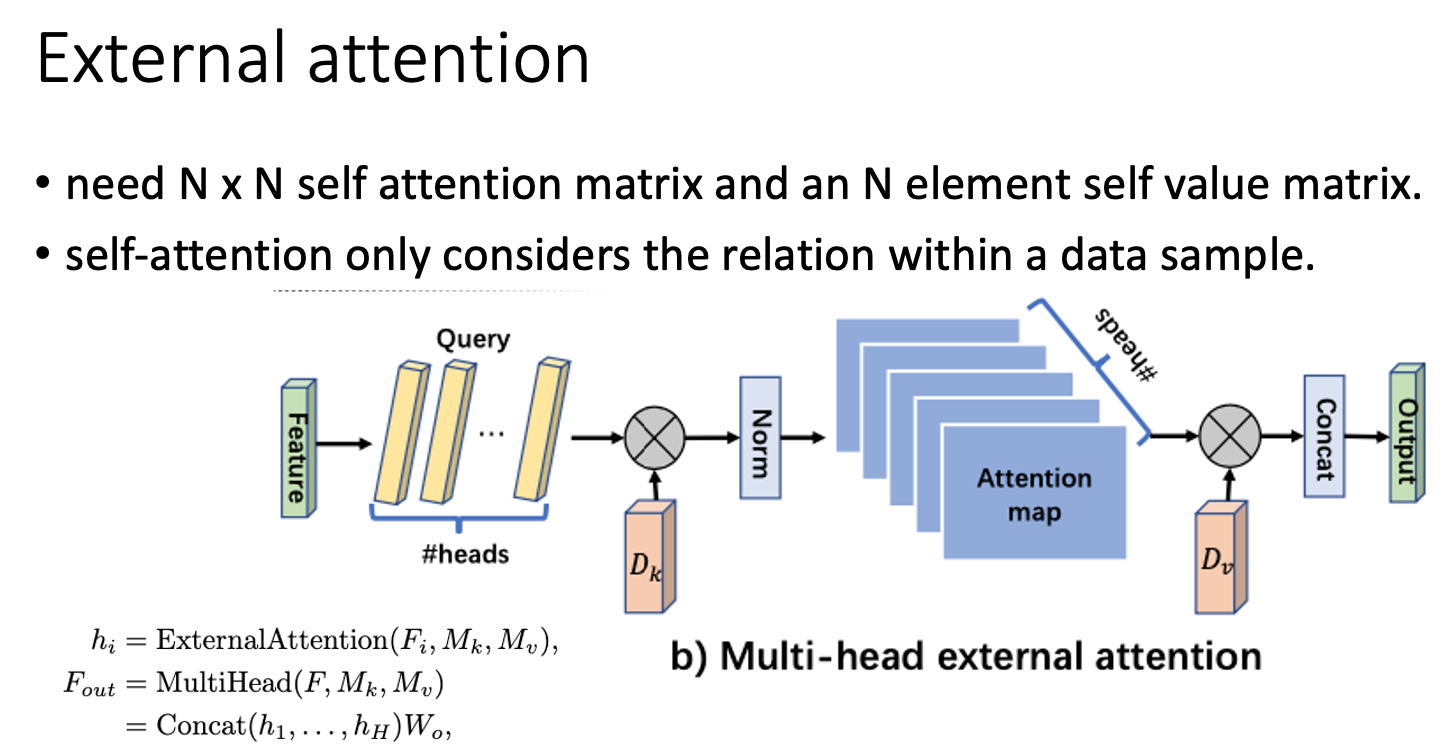

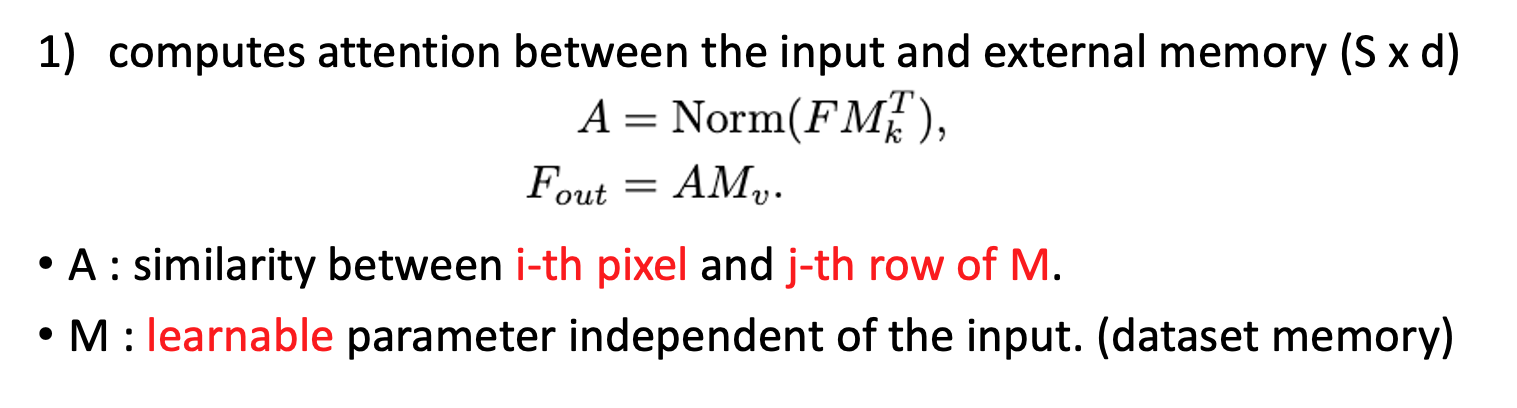

external attention을 사용함으로써 사용 memory가 적어지고 데이터셋 내의 데이터 간의 공유가 가능하여 regularization role을 하기도 한다.

ref.