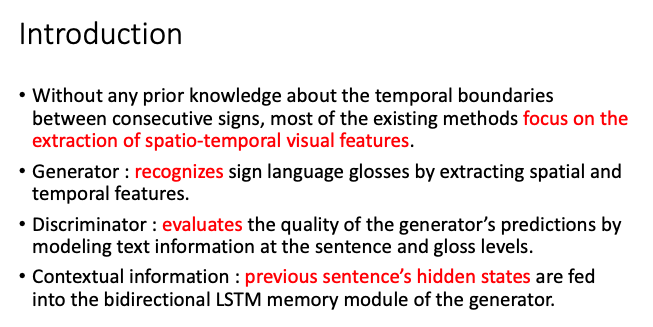

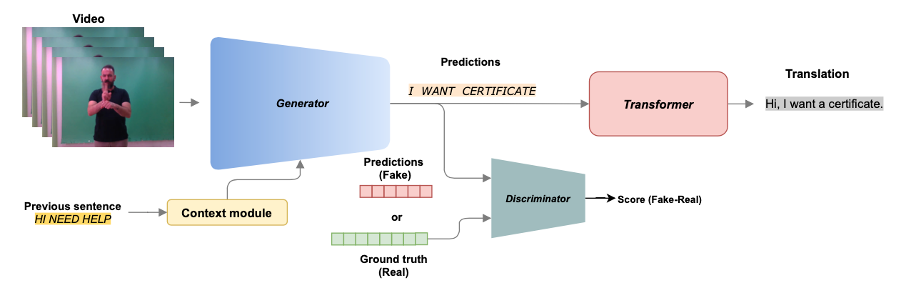

temporal boundary가 없는 continuous sign language recognition에서는 spatial-temporal visual feature를 추출하는데 집중되어 왔다. 또한, GAN의 아이디어인 generator와 discriminator 개념을 적용한 시도가 지금까지 없었고 이를 적용해 보았다고 한다. 각각의 대략적인 역할을 살펴보면 generator는 시공간 정보를 추출해 수화를 인식한다. generator로부터 예측된 값의 quality를 discriminator는 문장, 단어 수준으로 modeling하여 평가한다. 또한, 문맥적 정보를 추가하기 위해 이전 문장의 hidden state값을 generator의 LSTM memory module에 주입한다.

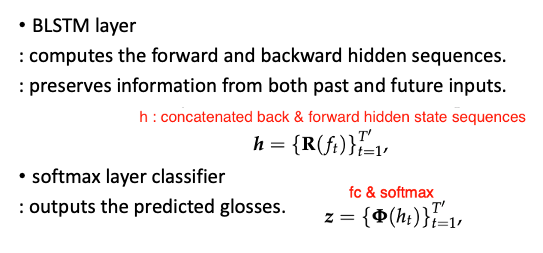

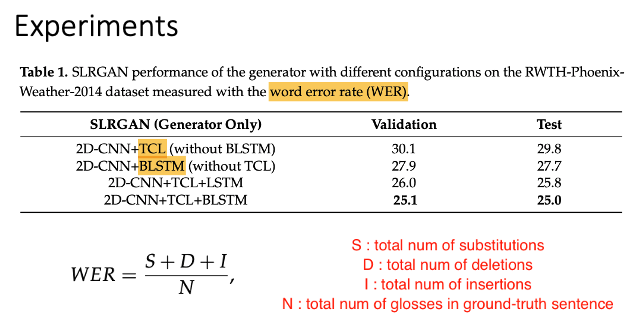

generator는 temporal 순서로 동영상의 frame을 받아서 2d cnn, temporal conv, pooling layer를 거쳐 vector를 생성한다. 그리고 bi-directional lstm에 모든 time에 대한 정보를 입력하여 예측을 한다. BLSTM은 전, 후 hidden sequences를 계산한다. 그리고 각각의 input값을 보유하고 있는다.

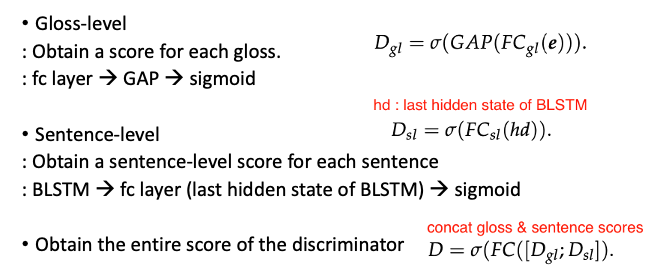

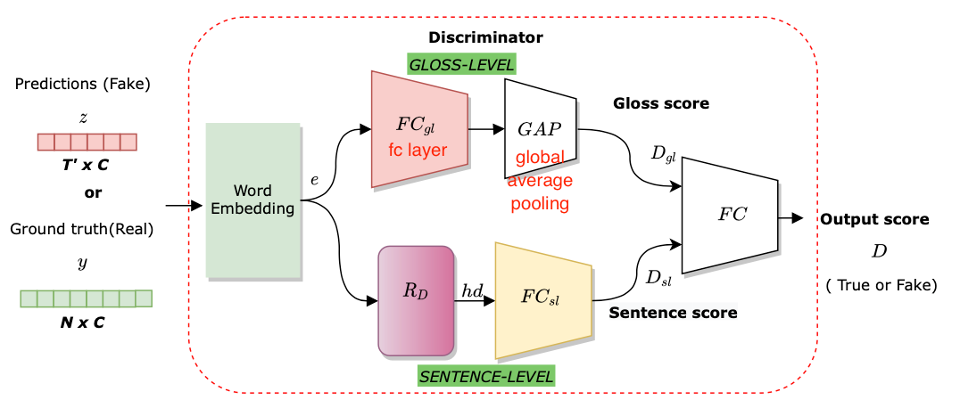

discriminator는 generator의 output이나 ground-truth를 입력 받아서 해당 값에 대한 점수를 0과 1사이로 나타낸다. 이때, 입력 값이 ground truth일 경우 one-hot vectors로 나타나있고 generator output일 경우 확률분포로 구성되어 있다.

해당 값을 word embedding의 linear projection처럼 fc layer를 통과시키며 낮은 차원으로 매핑한다.

sentence-level에서 fc layer에 BLSTM의 마지막 hidden state를 넣는 것은 entire sentence의 single output을 구하기 위함이다.

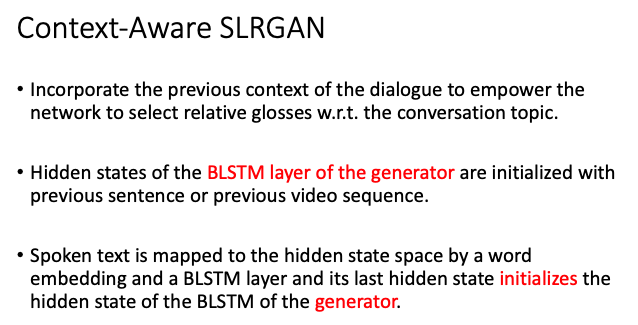

특이한 점이 context-aware라고 하여 수화도 대화이기 때문에 이전 정보를 추가적으로 주입하기 위해 사용하였다. 그래서 generator의 BLSTM hidden state는 이전 문장이나 비디오의 sequence로 initialized 된다.

ref.