논문 세미나 발표자료

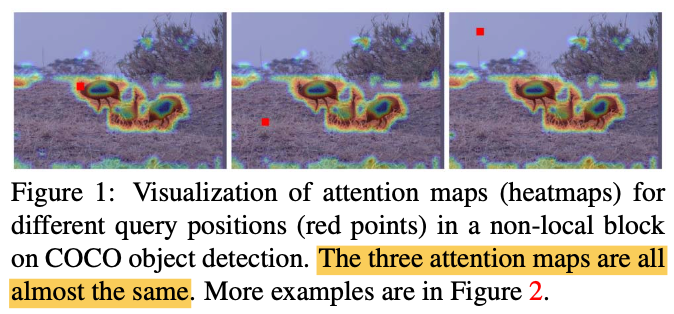

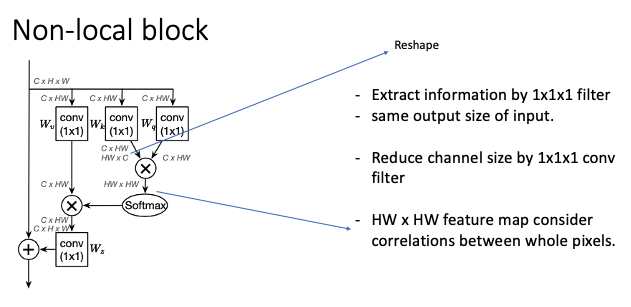

video일 경우, model을 통과하면서 long-range에 대한 정보를 획득할 수 있어야 한다. 기존에 공개된 non-local network가 self-attention mechanism을 사용하여 1개의 layer로 이를 수행했다. 해당 논문의 저자는 기존의 non-local module의 문제점을 발견하고 이를 개선하는 block을 제시했다.

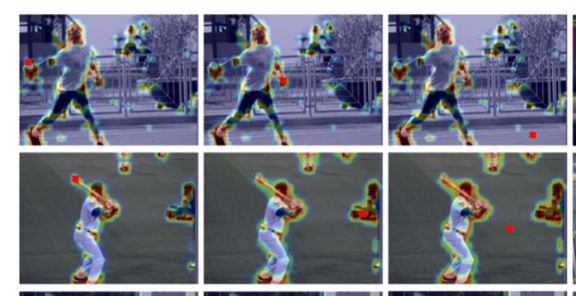

non-local block의 작용을 시각화와 통계적 분석을 통해 효용성을 검사하였다.

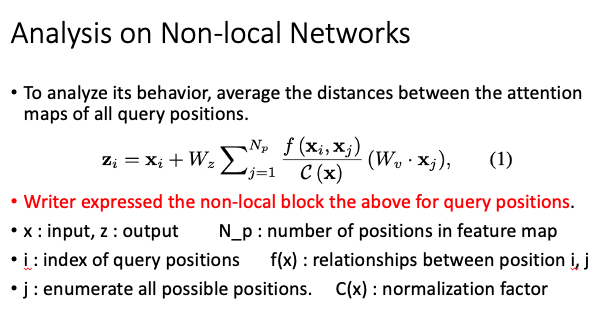

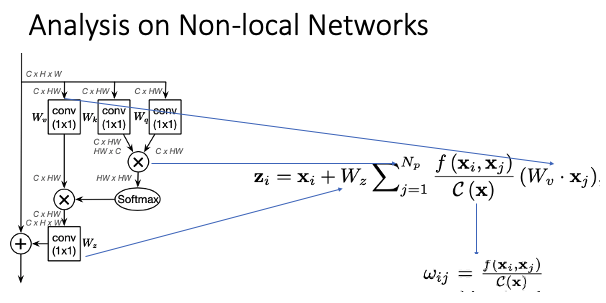

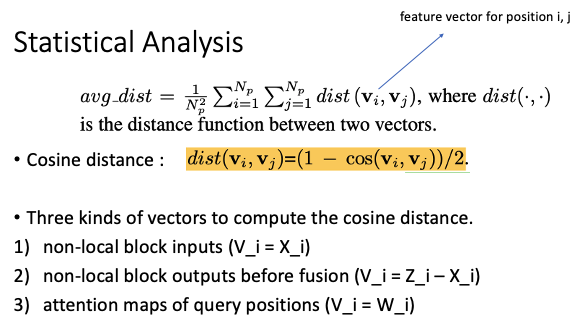

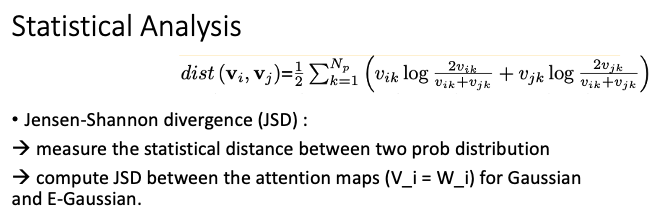

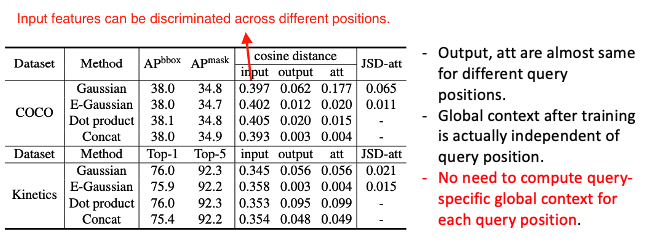

통계 분석은 각 extracted feature vector간의 평균 거리를 계산해 discriminate한 information을 뽑아냈는지 실험했다. 위의 표에서 볼 수 있듯이 non-local block을 통과한 후 추출된 feature vector간의 차이가 크지 않은 것으로 나타났다. 따라서 각 query position에 대해 global context를 계산하는 것은 비효율적이게 된다.

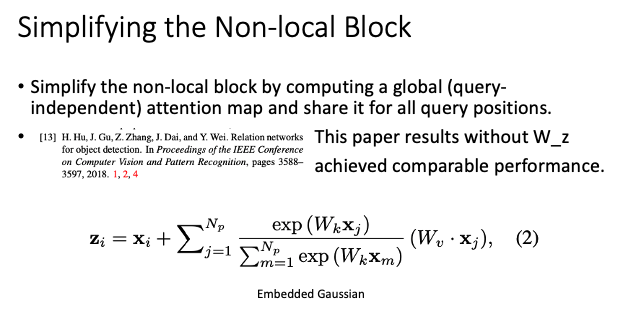

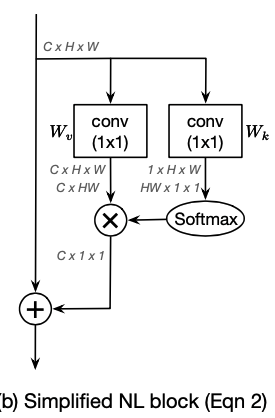

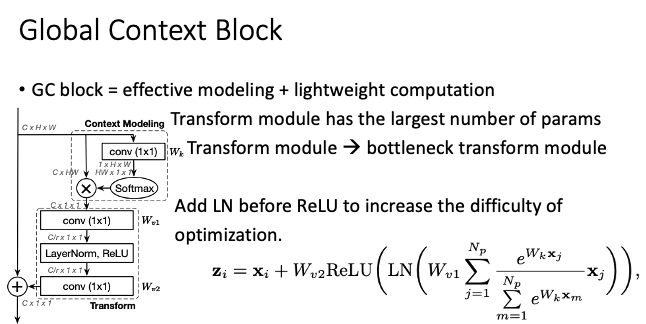

non-local block의 computing power를 줄이기 위해 global attention map으로 계산을 수행했다. 그리고 위의 슬라이드에 ref된 논문에서 W_z의 효과가 미미하다는 것을 적용하여 이를 삭제했다. 도식은 아래와 같다.

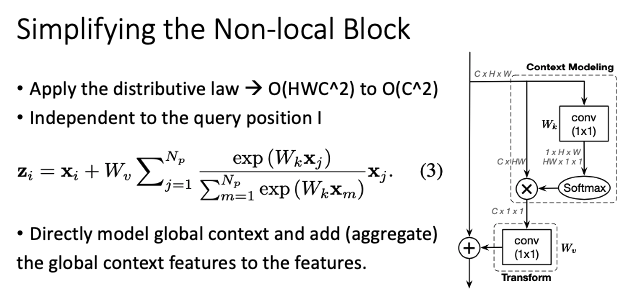

분배법칙을 적용하여 계산 복잡도를 더욱 낮추었고 query position에 대해 독립적이다. 이를 다양한 task에 적용했을 때, 결과는 아래와 같다.

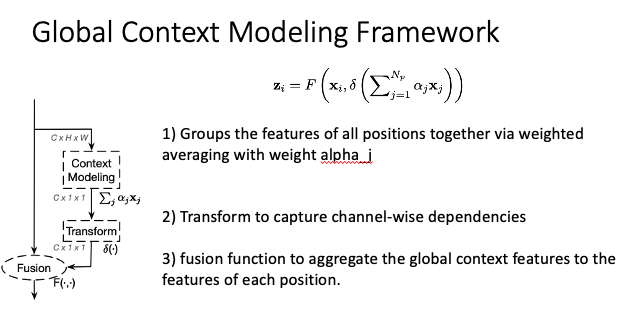

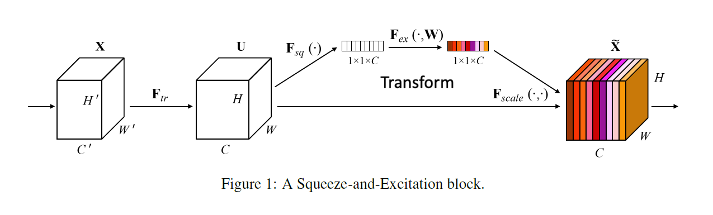

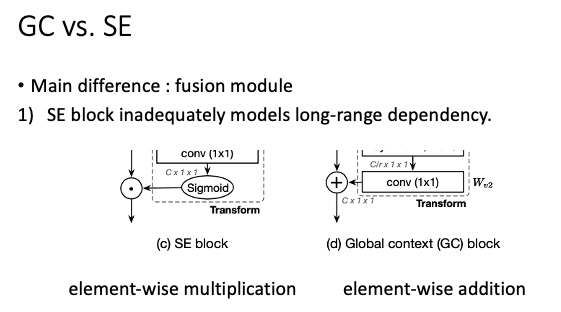

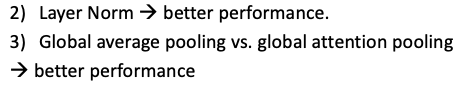

Global context modeling framework를 제시하였다. SE block과 매우 유사한 형태를 보여준다.

GC block과 SE block의 가장 큰 차이점은 global context modeling framework에서 fusion module에 있다. SE block은 vector를 matrix에 더하는 형태이고 GC block은 matrix와 matrix를 더한다. 따라서 GC block이 좀 더 다양한 feature vector를 추출할 수 있다.

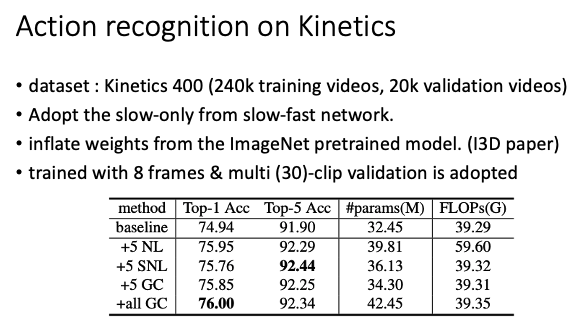

논문에서는 object segmentation, action recognition 등 다양한 종류의 vision task를 실험했는데 나는 action recognition만 가져왔다. 정확도는 매우 근사한 차이를 보여주었지만 FLOPs가 매우 크게 낮아진 것을 볼 수 있다.

ref.

'AI > Paper' 카테고리의 다른 글

| SMART Frame Selection for Action Recognition (2020) 리뷰 (0) | 2021.05.24 |

|---|---|

| Spatial-temporal pooling for action recognition in videos (2021) 리뷰 (0) | 2021.05.18 |

| ViViT: A Video Vision Transformer (2021) 리뷰 (0) | 2021.05.03 |

| Video Transformer Network (2021) 리뷰 (0) | 2021.04.30 |

| MoViNets: Mobile Video Networks for Efficient Video Recognition (2021) 리뷰 (0) | 2021.04.26 |