Transformer를 사용해 video classification을 하는 논문을 찾다가 나왔다. 특별한 내용이 없는 논문 --> 간략하게 설명

Abstract

transformer base의 video recognition을 위한 VTN (Video Transformer Network)을 제안했다. 기존의 방식으로 3D CNN이 가장 많이 제시되었다. NLP 분야에서 유명한 transformer를 적용하여 whole video analysis를 single end-to-end pass로 recognition을 실시했다. Kinetics-400 dataset를 사용하였고 ablation study, accuracy & inference speed trade-off를 실험했다.

Introduction

vision 분야는 recognition, classification에서 convNets에 크게 의존해왔다. 특히, video는 3D convnets을 사용한 논문이 대다수였다. 또한, optical flow, multi-view inference등과 같이 RGB video외에 추가적인 정보를 활용한 model도 많았다.

저자는 video의 frame (sequence of images)이 NLP의 sequence of words (or characters)와 매우 닮아있다고 생각고 transformer에 적용하는 방법을 제안했다.

Related Work

1) Spatial-temporal networks

- 3D ConvNets, I3D, etc

- Non-local Neural Network

- SlowFast

- X3D

2) Transformers in computer vision

- ViT, DeiT (image classification)

- DETR (object detection)

- VisTR (video instance segmentation)

3) Applying Transformers on long sequences

- Longformer

Video Transformer Network

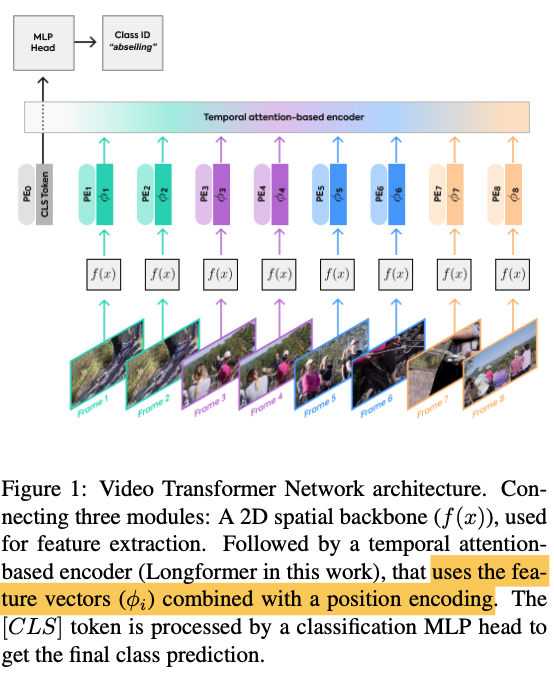

VTN은 data의 single stream을 사용하여 video 전체를 input값으로 받는다. architecture는 3 부분으로 나뉘어져 있다.

1) 2D spatial feature extraction model (spatial backbone)

2D image에 사용 되는 learned feature extraction module를 사용했다.

2) Temporal attention-based encoder

transformer는 동시에 처리가능한 token의 수가 제한돼있기 때문에 video와 같이 long inputs에서 최대 효율을 보일 수 없다. 따라서 해당 논문에서는 inference할 때 video 전체를 처리할 수 있도록 하기 위해 Longformer를 사용했다. (arxiv.org/abs/2004.05150)

BERT에서 사용되는 CLS (special classification token)를 features sequence 앞에 추가했다.

3) Classificatoin MLP

두 개의 linear layers에 각각 GELU activation function이 적용되었고 사이네는 dropout을 적용했다. 또한, input token은 layer normalizatoin을 수행했다.

Experiments

dataset의 비디오 길이가 짧아서 결과가 잘 안나오는거라고 한다.

ref : https://arxiv.org/abs/2102.00719

'AI > Paper' 카테고리의 다른 글

| GCNet: Non-local Networks Meet Squeeze-Excitation Networks and Beyond (2019) 리뷰 (1) | 2021.05.17 |

|---|---|

| ViViT: A Video Vision Transformer (2021) 리뷰 (0) | 2021.05.03 |

| MoViNets: Mobile Video Networks for Efficient Video Recognition (2021) 리뷰 (0) | 2021.04.26 |

| Squeeze-and-Excitation Networks (2018) 리뷰 (0) | 2021.04.20 |

| Quo Vadis, Action Recognition? A New Model and the Kinetics Dataset (2017) (0) | 2021.04.18 |